Una inteligencia artificial capaz de responder con precisión a preguntas como “¿Quién iba sentado a mi lado en el taxi cuando fui de compras la semana pasada?” ha surgido a partir de decenas de horas de video capturado con las Ray-Ban Meta Glasses. Según el documento de investigación, ‘EGAgent’, desarrollado conjuntamente por el equipo de investigación de Meta y la Universidad de Wisconsin, puede analizar videos largos de hasta una semana para responder a preguntas complejas. Se espera que esta tecnología marque el comienzo de una verdadera era de asistentes de IA a través de gafas inteligentes.

Procesando hasta 50 horas de video… Algo que la IA tradicional no podía hacer

Con la creciente aparición de dispositivos tipo gafas como las Ray-Ban Meta Glasses, Amazon Echo Frames y Snapchat Spectacles, estamos entrando en una era en la que los asistentes de IA observan y registran continuamente nuestra vida diaria. Sin embargo, hasta ahora, la IA solo podía comprender videos de unos pocos minutos, como máximo una hora. Comprender videos de una semana o un mes de duración era imposible. EGAgent, creado por el equipo de investigación de Meta, fue desarrollado para resolver este problema y puede analizar videos continuos en primera persona de hasta 50 horas de duración.

Los sistemas de IA existentes tenían dificultades para manejar videos largos debido a sus limitaciones en la cantidad de información que podían procesar a la vez. Además, era difícil realizar inferencias complejas que conectaran eventos que ocurrieron a lo largo de varios días. Por ejemplo, los sistemas existentes no podían responder adecuadamente a preguntas como “¿Con qué amigo específico me reuní esta semana?” o “¿Quién era la persona con la que me cruzaba repetidamente en una cafetería específica?”. EGAgent superó estas limitaciones adoptando un nuevo enfoque llamado ‘mapa de relaciones’.

Mapeando las relaciones entre personas, objetos y lugares… y registrando el tiempo

La tecnología central de EGAgent es el ‘mapa de relaciones’. Este mapa representa a las personas, objetos y lugares que aparecen en el video como puntos, y conecta estos puntos con líneas que representan sus relaciones. Las relaciones se clasifican en cuatro categorías: “conversó”, “actuó en conjunto”, “mencionó” y “usó”. Lo más importante es que cada relación registra información de tiempo, incluyendo cuándo comenzó y cuándo terminó. Por ejemplo, la relación se almacena con la hora exacta, como “Shura conversó con Alice desde las 3:50:21 hasta las 3:50:22”.

Este mapa de relaciones se crea automáticamente combinando la transcripción del audio del video con descripciones de las escenas. El sistema primero divide el video en segmentos de 30 segundos para describir las escenas, luego combina esto con el contenido de audio y, utilizando IA, extrae a las personas, los objetos y sus relaciones. Esta información extraída se almacena en una base de datos para su posterior búsqueda rápida. El mapa creado por el equipo de investigación a partir de datos experimentales de una semana contenía un total de 13,968 relaciones, la mayoría de las cuales eran interacciones entre personas o entre personas y objetos.

Una IA que planifica, busca y analiza… encuentra respuestas en varios pasos

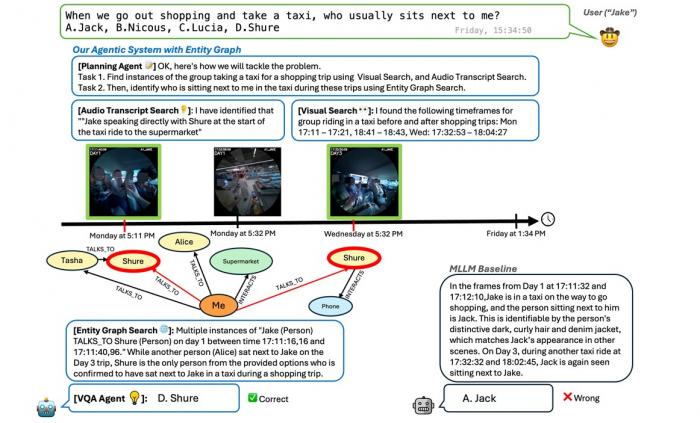

EGAgent no solo crea un mapa de relaciones, sino que también implementa un sistema que utiliza este mapa para responder preguntas. El sistema se divide en varias partes. Primero, una ‘IA de planificación’ divide las preguntas complejas en varias tareas más pequeñas. Luego, tres herramientas de búsqueda encuentran información de diferentes fuentes. A continuación, una ‘herramienta de análisis’ determina si la información encontrada es relevante para la pregunta. Finalmente, una ‘IA de respuesta’ sintetiza toda la información para crear la respuesta final.

Las tres herramientas de búsqueda examinan diferentes datos. La ‘herramienta de búsqueda de video’ almacena fotogramas de video extraídos a una velocidad de un fotograma por segundo y busca escenas relacionadas con la pregunta. La ‘herramienta de búsqueda de audio’ busca el contenido transcrito del habla de las personas en el video. La ‘herramienta de búsqueda del mapa de relaciones’ examina el mapa de relaciones creado anteriormente, combinando tiempo, nombres de personas y tipos de relaciones para encontrar relaciones relevantes.

La búsqueda del mapa de relaciones utiliza un enfoque inteligente. Inicialmente, busca condiciones que satisfagan la fecha, la hora, el nombre de la persona y el tipo de relación exactos. Si no se encuentra nada, afloja gradualmente las condiciones. Por ejemplo, ampliando el rango de tiempo, cambiando los nombres de las personas para que coincidan con nombres similares o eliminando la condición del tipo de relación. La información recopilada por cada herramienta de búsqueda se analiza y se acumula en una ‘memoria de trabajo’. Una vez completadas todas las tareas pequeñas, la IA de respuesta crea la respuesta final basándose en la evidencia acumulada.

Resultados experimentales: 57.5% de precisión… mejora significativa en la comprensión de las relaciones

El equipo de investigación probó EGAgent utilizando dos criterios de evaluación. ‘EgoLifeQA’ consiste en 500 preguntas de opción múltiple extraídas de 50 horas de video en primera persona capturado por seis personas que vivieron juntas durante una semana con gafas especiales. Las preguntas cubren temas útiles en la vida real, como encontrar objetos, recordar eventos pasados, identificar hábitos y analizar relaciones interpersonales.

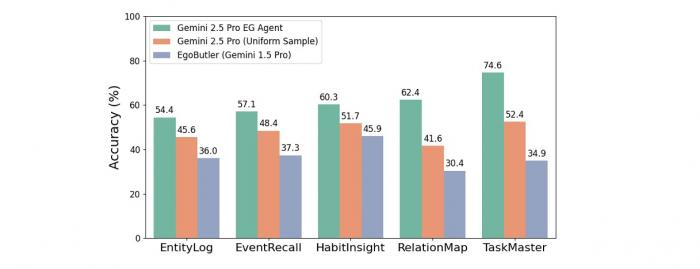

Los resultados experimentales mostraron que EGAgent logró una precisión del 57.5% en EgoLifeQA. Esta cifra es un 20.6% más alta que el récord anterior. En particular, en el elemento ‘RelationMap’, que requiere comprender las relaciones interpersonales, alcanzó una precisión del 62.4%, un aumento de 32% con respecto al récord anterior. También fue un 20.8% más alto que Gemini 2.5 Pro de Google. Además, en el elemento ‘TaskMaster’, que requiere una inferencia de tareas compleja, alcanzó un 74.6%, un aumento de 39.7% con respecto al récord anterior y un 22.2% con respecto a Gemini 2.5 Pro.

El equipo de investigación experimentó con varias combinaciones para determinar la importancia de cada herramienta de búsqueda. Cuando solo se utilizó la búsqueda de video, RelationMap obtuvo una puntuación baja del 28%, pero aumentó al 40% al agregar la búsqueda de audio. La combinación de todas las búsquedas del mapa de relaciones logró el mejor rendimiento, con un 53.6%. Esto demuestra que es esencial utilizar múltiples fuentes de información para comprender videos largos.

La comercialización de los asistentes de IA con gafas inteligentes… pero aún hay desafíos

La aparición de EGAgent significa que los asistentes de IA basados en gafas inteligentes están un paso más cerca de la realidad. Mientras que los sistemas existentes solo podían procesar fragmentos de video cortos o eventos independientes, EGAgent puede comprender y recordar experiencias continuas de más de una semana. Esto demuestra la posibilidad de crear un asistente de IA verdaderamente “siempre activo” que pueda observar continuamente la vida diaria del usuario y comprender el contexto.

Sin embargo, como reconocen los investigadores, todavía hay tareas pendientes. La IA puede cometer errores durante el proceso de creación del mapa de relaciones, y el rendimiento puede disminuir si no puede identificar con precisión quién está hablando. Además, EGAgent tarda un promedio de 2 a 3 minutos en responder a una pregunta, lo que dificulta obtener una respuesta inmediata. El equipo de investigación afirma que cambiar el método de búsqueda de voz puede aumentar la velocidad de procesamiento en 3.6 veces, pero la precisión disminuiría en 6.8 puntos porcentuales.

El equipo de investigación identificó margen de mejora a través de experimentos que asumían un sistema perfecto. Si se utilizara una búsqueda perfecta que conociera el intervalo de tiempo correcto, la precisión podría aumentar hasta el 68.7%, lo que demuestra que la tecnología para encontrar el momento exacto en el video es clave para mejorar el rendimiento. En particular, la herramienta de búsqueda de video demostró una alta precisión del 85.7% incluso en intervalos de 10 segundos, lo que demuestra su excelente capacidad para percibir el tiempo.

Nuevos desafíos en la protección de la privacidad y la ética de la IA

El desarrollo de la IA de comprensión de video largo como EGAgent plantea nuevos problemas en la protección de la privacidad y la seguridad de los datos. Un video en primera persona de una semana de duración contiene información muy sensible sobre la vida diaria, las relaciones interpersonales, los lugares visitados y los hábitos del usuario. Si bien los datos experimentales utilizados por el equipo de investigación desenfocaron automáticamente las caras y la información de identificación personal y eliminaron el contenido de audio sensible, se necesitarán medidas de protección de la privacidad mucho más sólidas en los servicios reales.

En particular, el mapa de relaciones almacena de forma estructurada las redes de relaciones interpersonales, lo que significa que la información sobre quién se reunió con quién, cuándo y dónde se registra permanentemente en la base de datos. Si estos datos se filtran o se utilizan con fines maliciosos, podría provocar graves violaciones de la privacidad. Por lo tanto, para que los asistentes de IA con gafas inteligentes se conviertan en productos reales, es esencial incluir funciones como el procesamiento solo en el dispositivo, el cifrado de datos y la capacidad para que los usuarios eliminen los datos directamente.

Además, a medida que el nivel de “memoria” y “comprensión” de la IA de la vida diaria del usuario aumenta, surgirán preguntas filosóficas y éticas sobre la relación entre la IA y los humanos. ¿Es una verdadera “ayuda” o una “vigilancia” excesiva si un asistente de IA conoce todos los hábitos, preferencias y relaciones interpersonales del usuario? La tecnología desarrollada por el equipo de investigación es ciertamente innovadora, pero su uso debe estar respaldado por una cuidadosa discusión social y regulación.

Finalmente, esta investigación también tiene un significado importante para la industria de la IA en Corea. Meta tiene su propio dispositivo tipo gafas, las Ray-Ban Meta Smart Glasses, lo que le da la ventaja de poder crear tanto el hardware como el software. Las empresas nacionales también deben centrarse no solo en el desarrollo de algoritmos, sino en una estrategia integral que conecte los dispositivos tipo gafas y los servicios de IA. En particular, Samsung Electronics y LG Electronics, que son competitivas en los campos de los teléfonos inteligentes y los dispositivos AR/VR, podrían iniciar el desarrollo de la IA de comprensión de video largo utilizando estos recursos.

Preguntas frecuentes (※ Estas preguntas frecuentes fueron redactadas por nuestro medio basándose en el informe de referencia).

P1. ¿En qué se diferencia EGAgent de la IA existente?

R. La IA existente solo puede procesar videos cortos y su límite es de unos pocos minutos a una hora. Por otro lado, EGAgent puede comprender videos de hasta una semana (50 horas) y comprender las relaciones entre eventos que ocurren a lo largo de varios días. En particular, almacena las relaciones entre personas, objetos y lugares junto con la información de tiempo en un mapa, lo que le permite responder con precisión a preguntas como “¿Con qué amigo específico me reuní la semana pasada?”.

P2. ¿Es segura la información personal de los videos grabados con gafas inteligentes?

R. Los datos utilizados por el equipo de investigación desenfocaron automáticamente las caras y la información de identificación personal. Sin embargo, en los servicios reales, los videos diarios de una semana contienen mucha información sensible, por lo que son esenciales medidas de seguridad sólidas como el procesamiento solo en el dispositivo y el cifrado. En el futuro, será esencial que los productos reales incluyan funciones que permitan a los usuarios administrar y eliminar los datos directamente.

P3. ¿Cuándo se podrá incorporar esta tecnología a los productos reales?

R. Actualmente, EGAgent tarda de 2 a 3 minutos en responder a una pregunta, lo que dificulta obtener una respuesta inmediata. También hay margen de mejora en la precisión de la identificación de quién está hablando y los errores de la IA. Meta ya vende las Ray-Ban Meta Smart Glasses, por lo que es posible que una versión simplificada se incorpore en los próximos años, pero se necesitará más desarrollo tecnológico para una funcionalidad completa de comprensión de video de una semana.

El documento de referencia citado en el artículo está disponible en arXiv.

Título del informe: Agentic Very Long Video Understanding

Este artículo fue escrito utilizando ChatGPT y Claude.

■ Este artículo es proporcionado en colaboración con el medio especializado en IA ‘AI Matters’. (☞ Ir al artículo original)

AI Reporter (Aireporter@etnews.com)